Table des matières

L’analyse de logs est une stratégie SEO d’optimisation d’un site pour les moteurs de recherche qui vise à exploiter les fichiers de logs serveur en vue d’interpréter les mouvements, le passage des robots de Google lorsqu’ils crawlent les pages de votre site Internet.

Vous nous direz, quel est le but de cette manœuvre ? L’objectif est de comprendre la façon dont les crawlers explorent votre site, d’analyser leur comportement et d’identifier des failles, des mauvaises pratiques SEO qui nuisent au budget Temps, couramment appelé “budget crawl”, accordé par Google pour naviguer sur votre site. En effet, il faut savoir que Google ne crawle jamais un site dans son intégralité dès son premier passage. C’est d’ailleurs pour cette raison que, lorsque vous utilisez l’opérateur de commande Google cache: suivie d’une URL dans le célèbre moteur de recherche, la date et l’heure qui s’affichent, correspondant au moment où Googlebot a visité votre page pour la dernière fois, sont différentes d’une page à l’autre.

L’analyse de logs permet de tirer profit d’un maximum d’informations liées à la manière dont les spiders vont visiter vos pages. Elle vous permet de savoir quelle(s) partie(s) de votre site les bots de Google crawlent le plus et, a contrario, quelle(s) partie(s) ils ne visitent presque jamais. L’analyse de logs est donc un véritable outil d’aide à la décision pour acheminer votre site vers les plus hauts sommets de la SERP Google car, en SEO, le principe est simple : plus vous facilitez le parcours des robots sur votre site web, plus vous augmentez vos chances d’avoir un meilleur positionnement, y compris sur des mots-clés ultras concurrentiels. L’analyse de logs permet souvent de “désasphyxier” l’index de Google.

L’analyse de logs va certes vous permettre de tirer un certain nombre d’enseignements cruciaux sur votre site, mais vous allez également pouvoir appliquer un certain nombre de recommandations en vue de concentrer le crawl des moteurs de recherche sur les pages les plus stratégiques de votre site, au détriment des pages jugées secondaires, et de corriger les erreurs techniques qui pourraient freiner le passage des moteurs et nuire au budget crawl. Ce faisant, en mettant en place les préconisations issues de la première analyse, vous pourrez comparer les résultats lors d’une seconde étude comparative. L’objectif ultime est de focaliser la fréquence de crawl sur un nombre plus restreint de pages, sous réserve qu’il s’agisse effectivement des pages les plus pertinentes et les plus importantes d’un point de vue business, celles sur lesquelles vous avez un réel intérêt à vous positionner sur des tops requêtes.

À quoi ressemblent les logs serveur d’un site Internet ?

Les logs serveur sont un fichier, situé sur votre hébergement, constitué de milliers de lignes qui rapportent l’activité, c’est-à-dire le nombre de connexions ayant eu lieu sur votre site à un instant T, l’idéal étant de suivre les logs en continu afin d’avoir une vision à plus long terme du comportement de Googlebot.

Cette mine d’informations se compose de plusieurs données :

- L’horodatage, soit la date et l’heure de la tentative d’accès à votre site,

- l’IP client, soit l’adresse de l’hôte ayant effectué la requête au serveur,

- L’url cible,

- Le navigateur utilisé,

- Le système d’exploitation,

- La réponse serveur (entête HTTP),

- Le nombre de pages consultées,

- L’user-agent,

- Le poids de la page,

Analyse de logs VS analyse de crawl, quelles différences ?

Contrairement à l’analyse de logs, dont l’intérêt principal est d’identifier le comportement des robots des moteurs de recherche sur votre site, l’analyse de crawl se contente d’explorer votre site en suivant les liens présents dans chacune des pages. On appelle cela “scanner” un site web pour en extraire un maximum d’informations capitales.

L’analyse de crawl permet d’avoir un aperçu global de la santé de votre site en remontant notamment les liens internes erronés qui pointent vers des pages en 404, les liens redirigés, les liens qui pointent vers des pages utilisant le protocole HTTP au lieu du protocole HTTPS, les pages n’ayant pas de balise title, de balise canonical ou de balise hreflang, les h1 manquants ou en doublon, des metas description vides ou dupliqués, les pages en noindex et nofollow, etc.

Bref, l’analyse de crawl permet de remonter des problèmes évidents de crawl ou d’indexation là où l’analyse de logs, qui fait parallèlement le même travail, va aller plus loin en pistant directement les robots, car ce sont eux qui font ou défont le positionnement d’un site dans l’index de Google. La plupart du temps, l’analyse de logs regroupe les pages par blocs groupes de pages afin de tirer des conclusions générales sur des pans entiers de votre site, ce qui permet de faciliter l’interprétation des résultats et d’éviter l’effet de loupe qui n’est pas nécessairement l’effet recherché en analyse de logs où, bien au contraire, on cherche à dégrossir un maximum et à prendre du recul pour appliquer des recommandations globales.

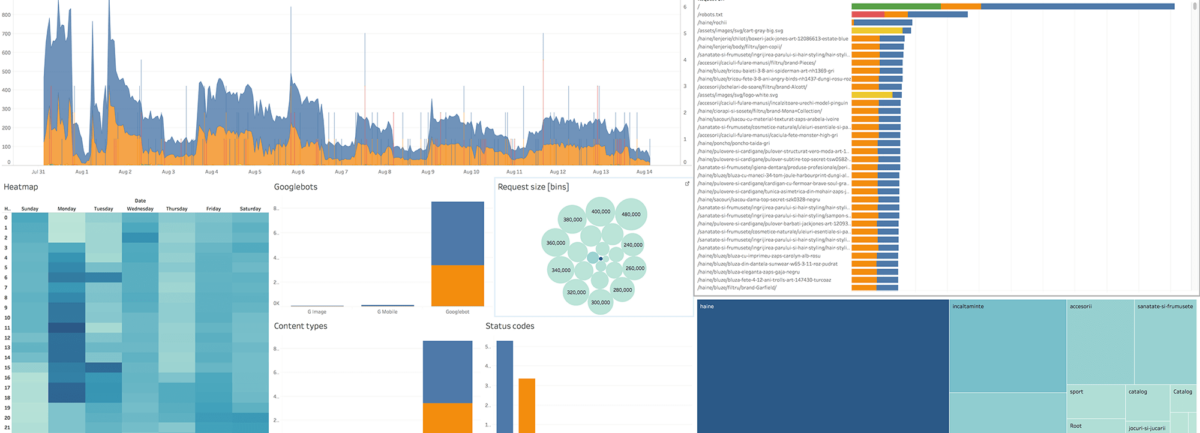

Parmi les outils dédiés à l’analyse de logs, YATEO recommande :

- Oncrawl et Botify pour les gros projets qui nécessitent un rendu visuel avancé ;

- Screaming Frog SEO Log File Analyser ou Seolyzer pour les projets de plus petite taille.

Enfin, on le rappelle ici, mais il est inutile de lancer une analyse de logs sur des petits sites ayant une faible volumétrie de pages indexées. L’analyse de logs doit être réservée à des sites de plusieurs milliers de pages au minimum, des sites d’envergure à l’arborescence complexe, le but de l’analyse de logs étant de “nettoyer” un site en profondeur et de trancher dans le vif afin d’obtenir des résultats concrets très rapidement.

Vous souhaitez mettre en place une analyse de logs sur votre site e-commerce?

Suivez-nous